何謂局部最小值?如何避免陷入局部最小值?

何謂局部最小值?

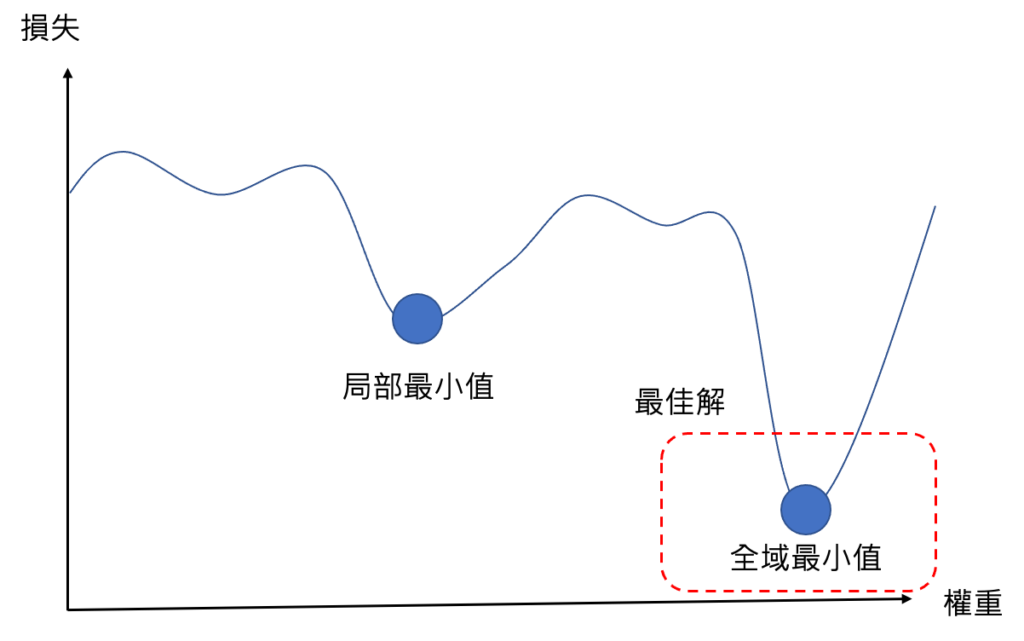

機器學習在訓練AI模型的時候,其實是透過梯度下降法,進行最佳權重的查找。而最佳權重其實是在損失函數空間當中,找一個最低點,最低點代表損失最小值,代表在此點上的權重,是最佳權重。

但是在實際運作情形下,損失空間是相當複雜的,會有出現一個常見的問題,就是在損失空間裡,會出現一個局部最小值,而在梯度下降法進行的過程中,一旦進入到局部最小值,這時候就會因為梯度不明顯,而導致難以跳脫出局部最小值,這時候我們可能就會以為這時候的解是最佳解,但事實上是錯誤的。

如何跳脫局部最小值?

實際上該如何避免陷入局部最小值呢?

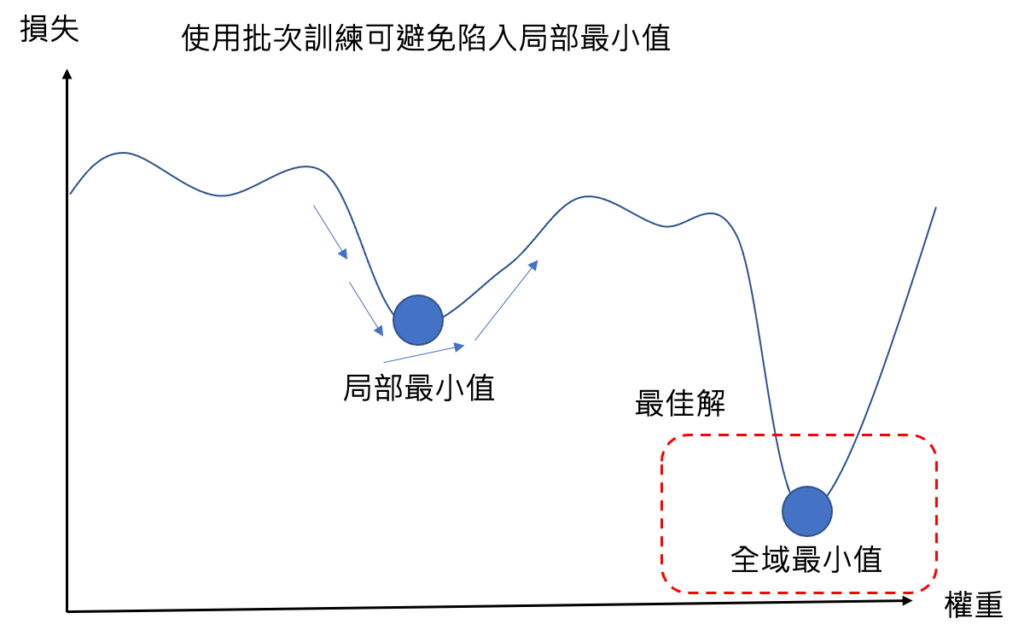

避免陷入局部最小值的方法有許多種方法,這邊提一個我們在上一篇提到的批次訓練法,使用批次訓練法是可以避免陷入局部最小值的,因為批次訓練的梯度下降法,是每一次都隨機抽樣一定的樣本數,進行梯度的計算,而這種隨機性就有可能當我們在訓練過程中落入局部最小值時,往不同的方向走就有機會跳脫出局部最小值並且往全域最小值行走,進而得到最佳解。

想要看更多AI文章,更了解學習脈絡,請參考AI學習路線圖。

[參考資料]:

2.機器學習與人工神經網路(二):深度學習(Deep Learning)

[類神經網路基礎系列專文]:

1.類神經網路(Deep neural network, DNN)介紹

3.類神經網路—啟動函數介紹(一): 深入解析Relu與Sigmoid函數:如何影響類神經網路的學習效果?

4.類神經網路—啟動函數介紹(二): 回歸 vs. 分類: 線性函數與Tanh函數之原理探索

5.類神經網路—啟動函數介紹(三): 掌握多元分類的核心技術:不可不知的softmax函數原理

6.類神經網路—啟動函數介紹(四): 如何選擇最適當的啟動函數?用一統整表格讓您輕鬆掌握

8.類神經網路—反向傳播法(一): 白話文帶您了解反向傳播法

10.類神經網路—反向傳播法(三): 五步驟帶您了解梯度下降法

11.類神經網路—反向傳播法(四): 揭開反向傳播法神秘面紗

12.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

13.類神經網路—反向傳播法(五): 用等高線圖讓您對學習率更有感

[機器學習基礎系列專文]:

1.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

[類神經網路延伸介紹]:

1.卷積類神經網路(Convolution neural network,CNN)介紹

2.遞迴類神經網路(Recurrent neural network,RNN)介紹

[ChatGPT系列專文]:

One Comment

Comments are closed.