從ChatGPT探索GPT的原理概念:少量數據的解方—遷移學習技巧

為什麼需要遷移學習?

遷移學習主要是用來解決只有少量數據的問題,當數據量不多,而且我們又要採用深度學習的技巧,去進行自然語言處理相關的應用或是影像辨識方面的應用,就需要採用遷移學習的技巧,才能讓我們站在巨人的肩膀上,去發揮深度學習的力量。

遷移學習概念

舉例來說,欲辨識某種稀有鳥類,我們手邊擁有的圖片數量不多,難以去直接訓練卷積類神經網路模型去進行影像辨識,因為就算採用這些圖片去做訓練,在數據量不多的情況下,模型開發出來的精確度也不會太好,為了要解決這樣的問題,這時候我們就需要採用遷移學習的技巧。

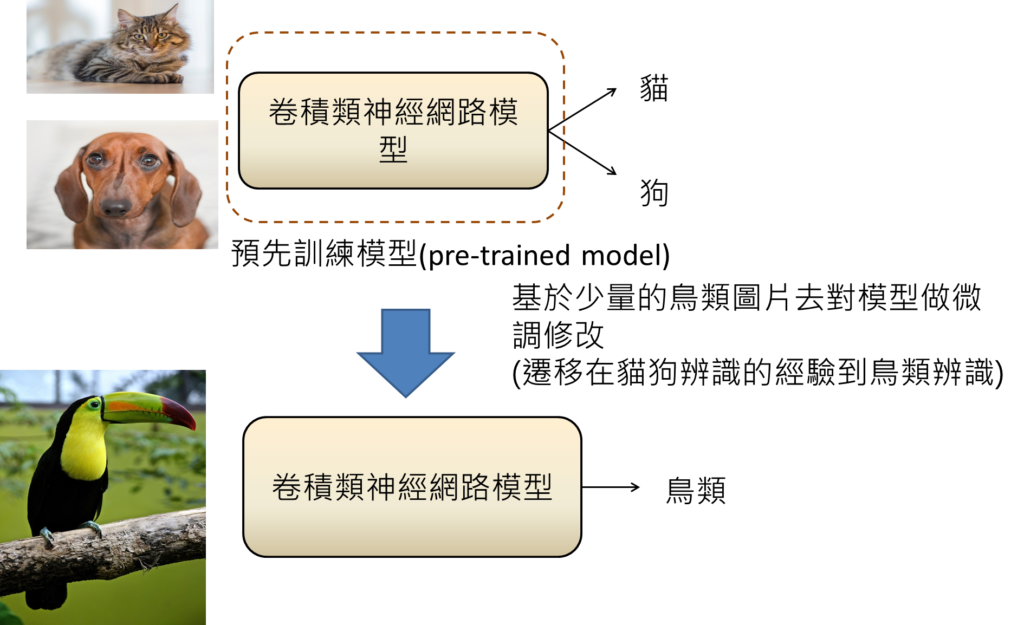

我們就會去以易取得的資料為基準,像是貓狗的圖片,就會有比較龐大的數據量,這時候因為數據量比較多,為了良好的學習,我們就會用比較深層的卷積類神經網路去做影像辨識的訓練。

基於貓狗辨識,訓練完成卷積類神經網路模型,這時候我們就稱作這樣的模型,是一個預先訓練的模型(pre-trained model),為了要去辨識鳥類,我們就讓預先訓練的模型,基於少量的鳥類圖片去對模型進行微調修改,才能讓這個模型去辨識鳥類。而這樣技巧就是遷移學習,因為是遷移在貓狗辨識的經驗到鳥類辨識。

為何遷移學習會奏效?

因為預先訓練模型可學習到辨識圖片通用的特徵,所以只是改變辨識種類,效果就會很好。這就好像從一個完全沒有機器視覺的機器,要教它影像辨識的任務,除了要告訴他辨別的種類以外,還要教它們如何找出圖片的特徵,才能加以判斷。那因為預先訓練的模型,已經有某種程度的機器視覺,它們已經有某種程度辨別圖片特徵的能力,所以這時候只是要再重新教導它們新的影像辨識任務,它們就可以學習起來,而且效果絕佳!

想要看更多AI文章,更了解學習脈絡,請參考AI學習路線圖。

[參考資料]:

2.機器學習與人工神經網路(二):深度學習(Deep Learning)

[類神經網路基礎系列專文]:

1.類神經網路(Deep neural network, DNN)介紹

3.類神經網路—啟動函數介紹(一): 深入解析Relu與Sigmoid函數:如何影響類神經網路的學習效果?

4.類神經網路—啟動函數介紹(二): 回歸 vs. 分類: 線性函數與Tanh函數之原理探索

5.類神經網路—啟動函數介紹(三): 掌握多元分類的核心技術:不可不知的softmax函數原理

6.類神經網路—啟動函數介紹(四): 如何選擇最適當的啟動函數?用一統整表格讓您輕鬆掌握

8.類神經網路—反向傳播法(一): 白話文帶您了解反向傳播法

10.類神經網路—反向傳播法(三): 五步驟帶您了解梯度下降法

11.類神經網路—反向傳播法(四): 揭開反向傳播法神秘面紗

12.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

13.類神經網路—反向傳播法(五): 用等高線圖讓您對學習率更有感

[機器學習基礎系列專文]:

1.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

[類神經網路延伸介紹]:

1.卷積類神經網路(Convolution neural network,CNN)介紹

2.遞迴類神經網路(Recurrent neural network,RNN)介紹

[ChatGPT系列專文]:

2.從ChatGPT探索GPT的原理概念:少量數據的解方—遷移學習技巧

3.ChatGPT是什麼?探索GPT原理:遷移學習(transfer learning)的奧秘—微調(fine-tuning)技巧

10 Comments

Comments are closed.