大型語言模型(large language model, LLM): 提示工程(prompt)

為什麼會有提示工程(prompt)?

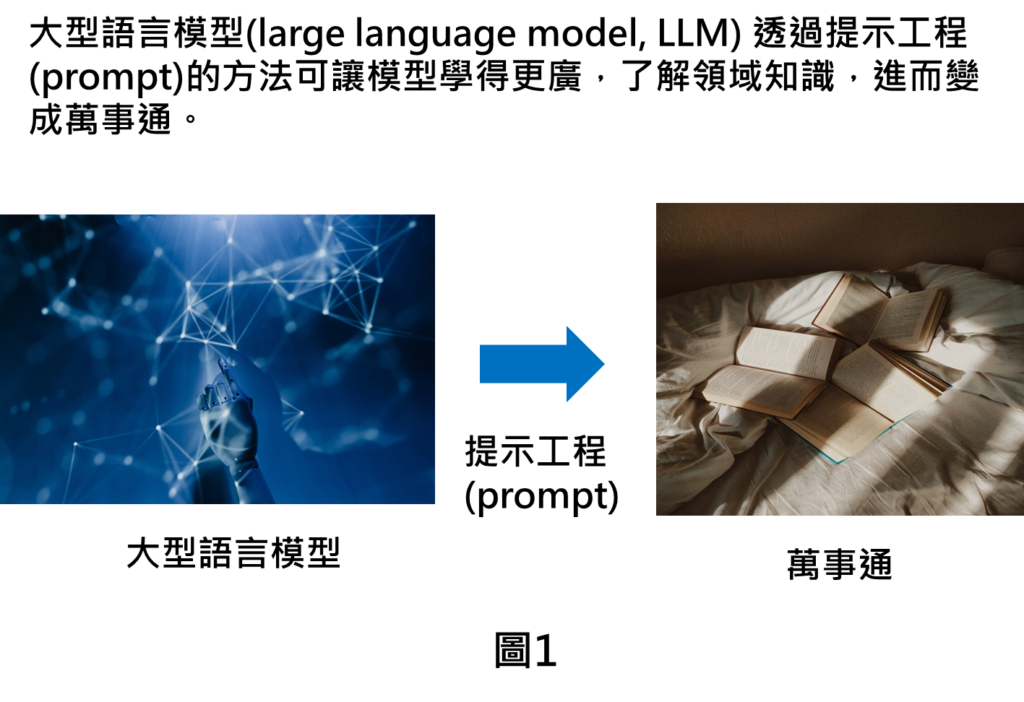

先前有提到大型語言模型是學習處理通用的自然語言任務,如果要處理特定任務,上次有提到過就需要對模型進行微調(fine-tuning),由於微調技術會修改模型參數,在實作的時候,就需要先考量到計算的資源,以及有沒有微調的數據。在資源比較缺乏的情況下,微調就會比較難執行。後來研究人員就發明的提示工程(prompt)的技術,這個技術主要是可以更方便讓模型進行學習,不需要耗費太多資源,因此,可透過這樣的方式讓模型大量學習,學習的更廣,進而變成萬事通。

提示工程(prompt)介紹

提示工程(prompt)原理

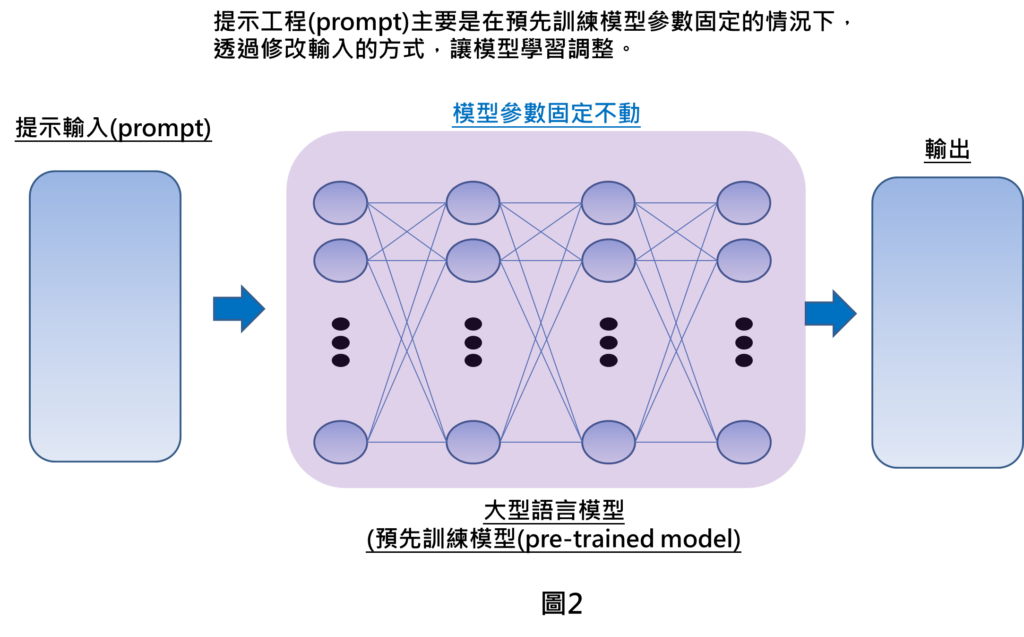

提示工程在運作的時候,完全是考量預先訓練模型參數是固定的情況下,只有透過修改輸入的方式,也就是在輸入部份加上一些提示,讓模型學習調整。因為不用更動參數,所耗費資源就會較小。透過這種方式,來讓模型得以處理特定任務,進而產生我們想要的輸出預測。

提示工程(prompt)範例說明

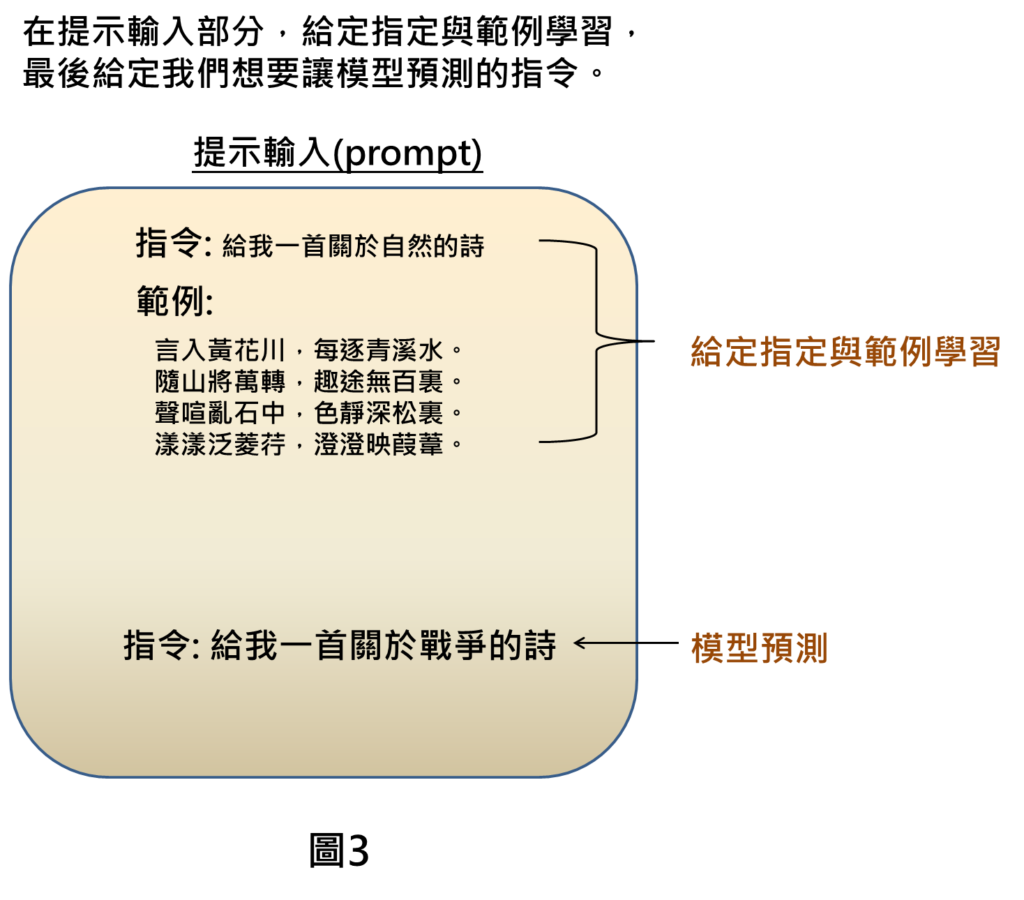

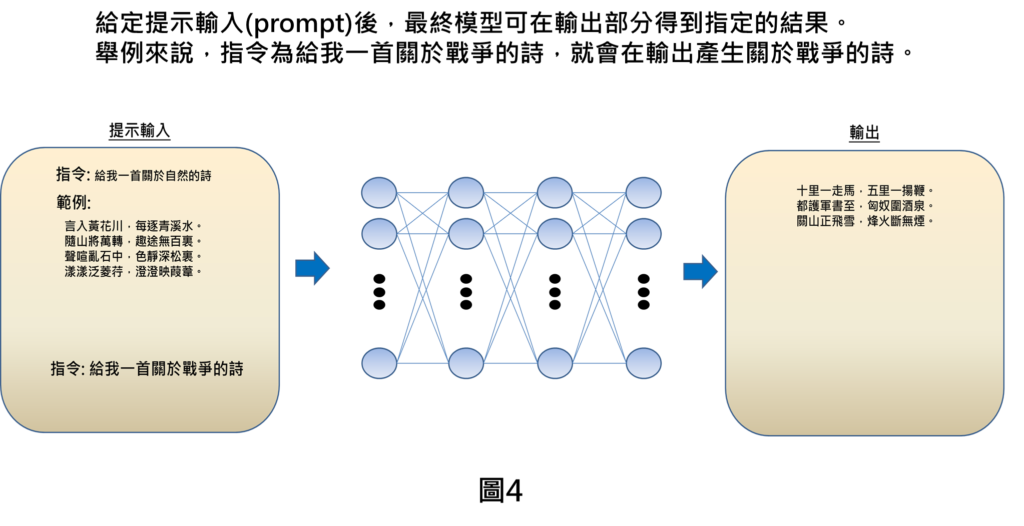

要給定提示輸入有許多種做法,我們這邊舉例其中一種作法,在提示輸入的部分,要先讓模型去學習,就需要給定指令與範例,例如指令為”給我一首關於自然的詩”,範例就是一首自然的詩,讓模型進行學習(此處是簡化代表就只有寫一個範例,實際上要讓模型學習就須要有多個範例)。然後給定我們想要模型幫我們預測的指令,這樣就可以完成提示輸入。

將提示輸入輸進去模型後,最終模型就會在輸出部分得到我們指定的結果。例如指令為給我一首關於戰爭的詩,就會在輸出產生關於戰爭的詩。如此一來,就可透過修改提示輸入的部分,讓模型也可應用在特定任務上。

提示工程(prompt)與微調(fine-tuning)比較

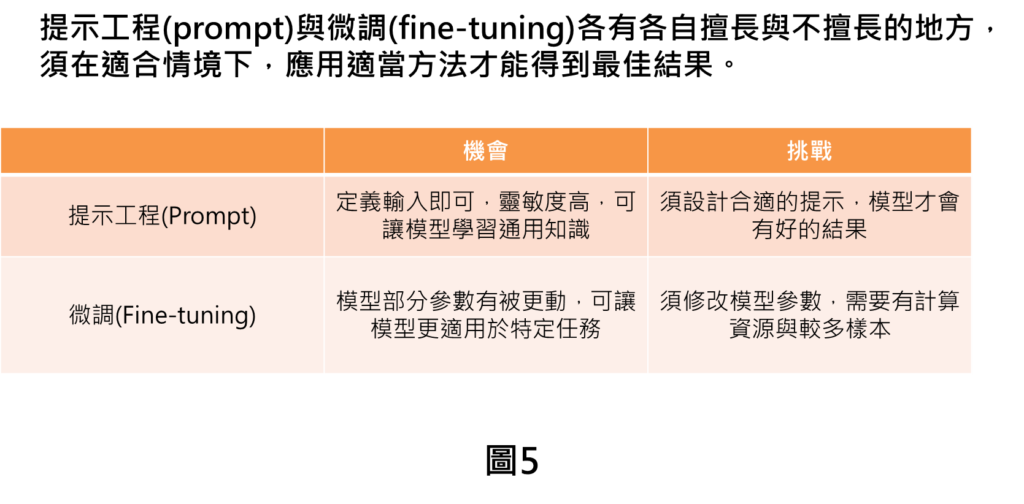

最終回顧一下將我們寫的此篇技術提示工程(prompt)與微調(fine-tuning)互相比較一下,

在提示工程的部分,好處是可透過給定輸入,讓模型學習調整,不需要去更動模型參數,讓模型可以學習更多知識,而比較需要考量的部分,就是需要設計合適的提示,模型才會有好的結果。

在微調的部分,好處是因為模型參數有被更動的情況,更可讓模型適用在特定任務上,比較需要考量的部分,就是須要有相對應的運算資源以及數據。

提示工程(prompt)與微調(fine-tuning)各有各自擅長與不擅長的地方,須在適合情境下,應用適當方法才能得到最佳結果。

結論

本篇文章帶您初探提示工程的技術,其中包含

- 提示工程的原理: 是透過給定提示輸入的方式來讓模型進行學習調整。

- 提示工程的範例: 須給定指令與範例讓模型學習,並在最後寫下指令得到我們想要的輸出。

- 提示工程與微調的比較: 提示工程(prompt)與微調(fine-tuning)各有各自擅長與不擅長的地方,須在適合情境下,應用適當方法才能得到最佳結果。

這樣的技術普遍運用在大型語言模型當中,在我們最近常見的ChatGPT上,也是需要給定指令來得到我們想要的解答。提示工程方法有許多種,目前只是簡單介紹,帶日後有機會在講解更多提示工程的方法。

想要看更多AI文章,更了解學習脈絡,請參考AI學習路線圖。

[相似文章]:

1.揭密大型語言模型(large language model, LLM) 變成專家的關鍵技術: 微調技巧(fine-tuning)

[參考資料]:

2.機器學習與人工神經網路(二):深度學習(Deep Learning)

[類神經網路基礎系列專文]:

1.類神經網路(Deep neural network, DNN)介紹

3.類神經網路—啟動函數介紹(一): 深入解析Relu與Sigmoid函數:如何影響類神經網路的學習效果?

4.類神經網路—啟動函數介紹(二): 回歸 vs. 分類: 線性函數與Tanh函數之原理探索

5.類神經網路—啟動函數介紹(三): 掌握多元分類的核心技術:不可不知的softmax函數原理

6.類神經網路—啟動函數介紹(四): 如何選擇最適當的啟動函數?用一統整表格讓您輕鬆掌握

8.類神經網路—反向傳播法(一): 白話文帶您了解反向傳播法

10.類神經網路—反向傳播法(三): 五步驟帶您了解梯度下降法

11.類神經網路—反向傳播法(四): 揭開反向傳播法神秘面紗

12.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

13.類神經網路—反向傳播法(五): 用等高線圖讓您對學習率更有感

[機器學習基礎系列專文]:

1.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

[類神經網路延伸介紹]:

1.卷積類神經網路(Convolution neural network,CNN)介紹

2.遞迴類神經網路(Recurrent neural network,RNN)介紹

[ChatGPT系列專文]: