ChatGPT是什麼?探索GPT原理:遷移學習(transfer learning)的奧秘—微調(fine-tuning)技巧

在上次文章從ChatGPT探索GPT的原理概念:少量數據的解方—遷移學習技巧 提到 遷移學習的重要性,此處我們則是要介紹遷移學習裡的一個特殊技巧稱之為微調技巧。我們會用三步驟帶大家認識微調的技巧。

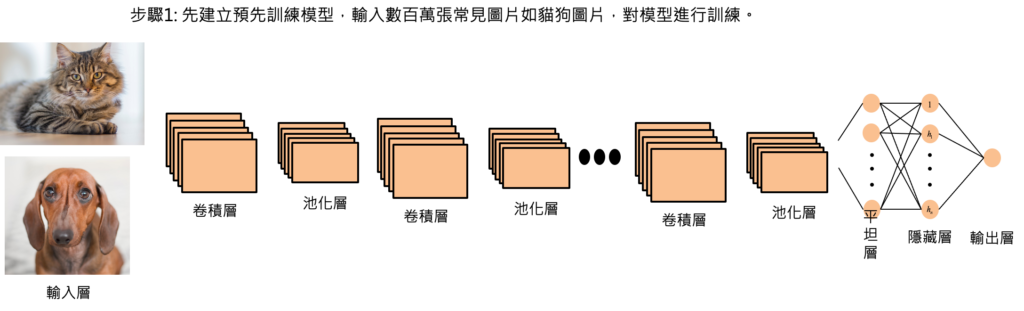

首先需要建立影像辨識的類神經網路,我們會採用卷積類神經網路,通常辨識效果要好,就需要有非常多層的卷積與池化層,又因為網路層數相當多,我們又稱學習方式為深度學習。

在網路非常深層的情況,就需要有足夠的圖片對網路進行訓練,否則會有欠擬合(under-fitting)的現象產生。

因此,我們會採用普遍常見的圖片對網路進行訓練,像是會如入數百萬張貓狗圖片。

如此一來,我們即可建立完成預先訓練模型。

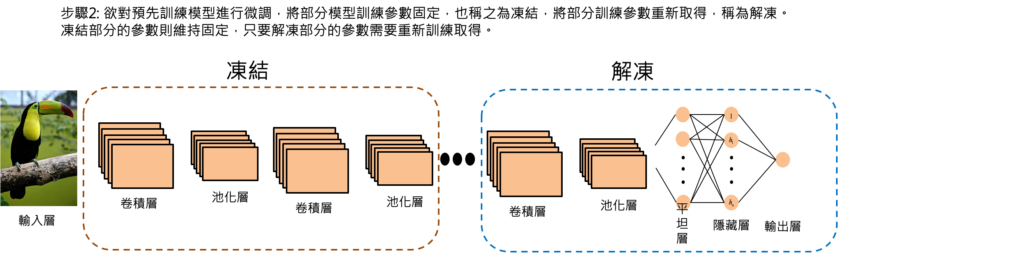

接下來,我們需要對預先訓練模型進行微調,我們就要先區分出凍結與解凍區域,凍結區域代表參數固定,如同先前預先訓練的結果,完全不改變參數。解凍區域代表我們要對這個區域的參數微調更動。

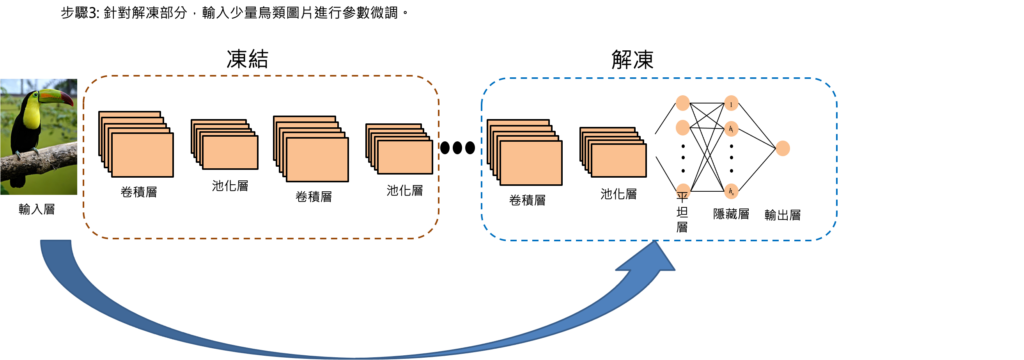

定義為凍結與解凍區域後,我們需要針對解凍部分,輸入少量稀有鳥類圖片在解凍區域對模型參數進行微調。

微調完成之後,我們即可獲得鳥類的影像辨識模型。

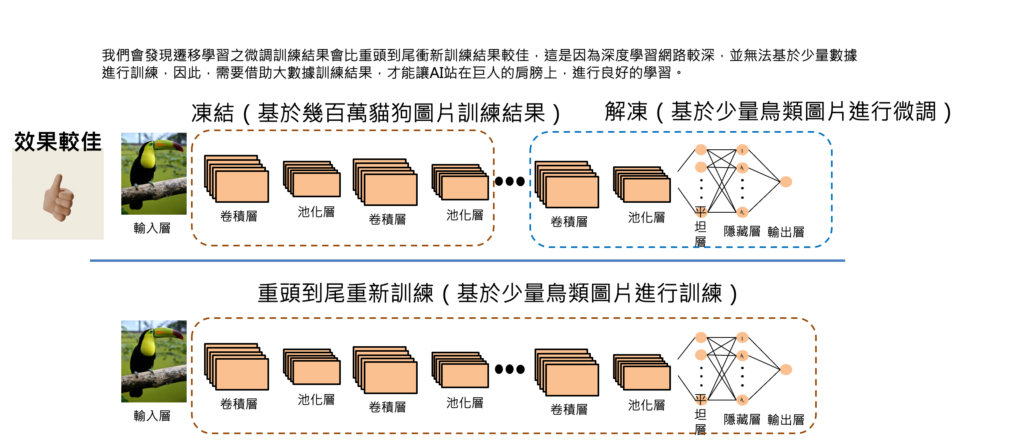

我們會發現用遷移學習的微調技巧所訓練出來的影像辨識模型會優於重頭到尾重新訓練的影像辨識模型。這是因為在微調技巧的架構下,凍結部分是基於幾百萬張貓狗圖片的訓練結果,這時候也代表模型已經有某種影像辨識的能力,差別只是在辨識任務需要從辨識貓狗轉變為辨識鳥類。

此時,我們就針對解凍部分進行參數微調,使得整體網路具有相當棒的影像辨識能力,同時又能針對我們要辨識的特定任務進行影像辨識。

而針對重頭到尾重新訓練的模型,則是會因為數據太少,再加上網路深度又很深的條件下,使得模型訓練出來是欠擬合,並不會有較好的辨識能力。

透過遷移學習的微調技巧,就可讓AI站在巨人的肩膀上,進行良好的學習!

想要看更多AI文章,更了解學習脈絡,請參考AI學習路線圖。

[參考資料]:

2.機器學習與人工神經網路(二):深度學習(Deep Learning)

[類神經網路基礎系列專文]:

1.類神經網路(Deep neural network, DNN)介紹

3.類神經網路—啟動函數介紹(一): 深入解析Relu與Sigmoid函數:如何影響類神經網路的學習效果?

4.類神經網路—啟動函數介紹(二): 回歸 vs. 分類: 線性函數與Tanh函數之原理探索

5.類神經網路—啟動函數介紹(三): 掌握多元分類的核心技術:不可不知的softmax函數原理

6.類神經網路—啟動函數介紹(四): 如何選擇最適當的啟動函數?用一統整表格讓您輕鬆掌握

8.類神經網路—反向傳播法(一): 白話文帶您了解反向傳播法

10.類神經網路—反向傳播法(三): 五步驟帶您了解梯度下降法

11.類神經網路—反向傳播法(四): 揭開反向傳播法神秘面紗

12.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

13.類神經網路—反向傳播法(五): 用等高線圖讓您對學習率更有感

[機器學習基礎系列專文]:

1.機器學習訓練原理大揭秘:六步驟帶您快速了解監督式學習的訓練方法

[類神經網路延伸介紹]:

1.卷積類神經網路(Convolution neural network,CNN)介紹

2.遞迴類神經網路(Recurrent neural network,RNN)介紹

[ChatGPT系列專文]:

3 Comments

Comments are closed.